El miércoles, Google presentó PaLM2, que es una familia de modelos de lenguaje básico comparable al modelo GPT-4 de OpenAI. En el evento Google I/O en Mountain View, California, Google reveló que ya usa PaLM 2 para potenciar 25 productos, incluido el asistente de IA conversacional Bard.

Como una familia de modelos de lenguaje grande (LLM), PaLM 2 ha sido entrenado en un volumen masivo de datos y realiza la predicción de la siguiente palabra, lo que produce el texto más probable después de una entrada rápida por parte de los humanos. PaLM significa Pathways Language Model yarcadaes una tecnología de aprendizaje automático creada en Google. PaLM 2 rastrea un archivo La palma originalAnunciado por Google en abril de 2022.

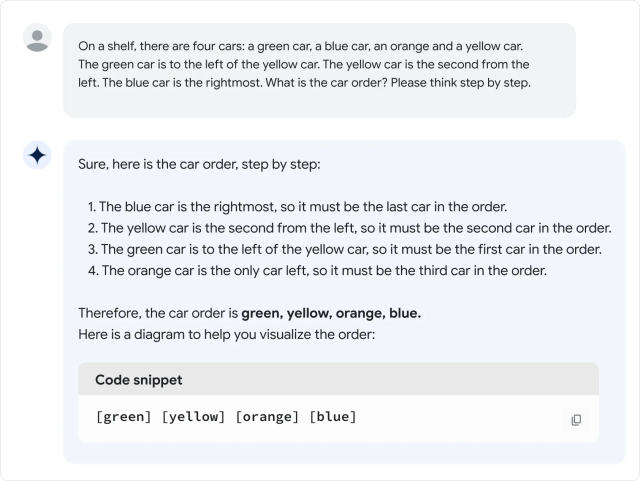

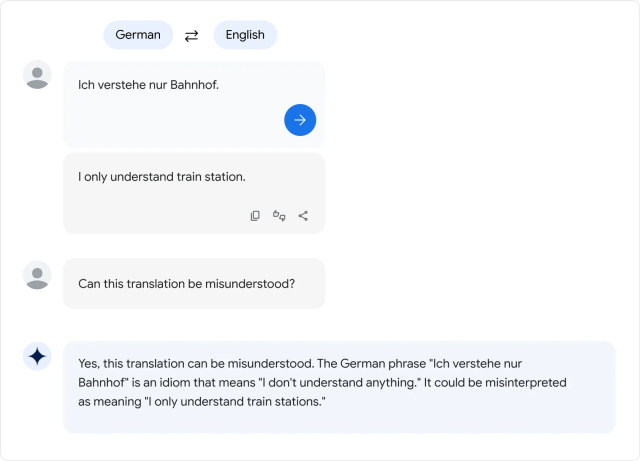

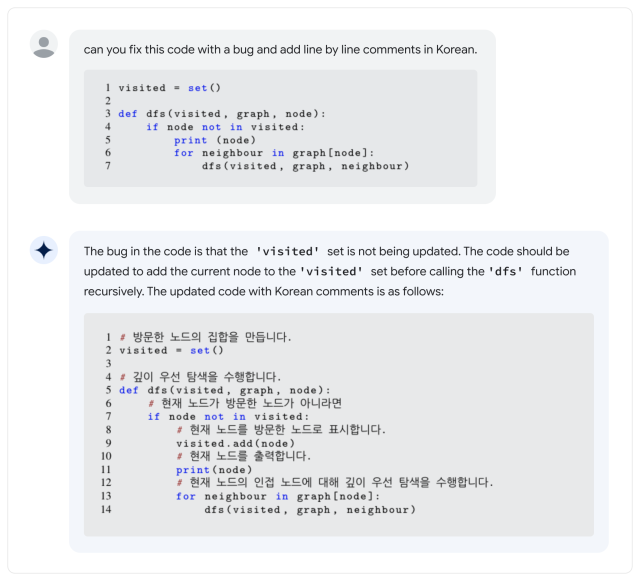

Según Google, PaLM 2 admite más de 100 idiomas y puede realizar «razonamiento lógico», generación de código y traducción multilingüe. Durante su discurso de apertura en Google I/O 2023, el CEO de Google, Sundar Pichai, dijo que PaLM 2 viene en cuatro tamaños: Gecko, Otter, Bison y Unicorn. Gecko es el más pequeño y se puede jugar en un dispositivo móvil. Además de Bard, PaLM 2 está detrás de las funciones de IA en documentos, hojas de cálculo y presentaciones.

Todo esto está muy bien, pero ¿cómo se compara PaLM 2 con GPT-4? En el Informe técnico PaLM 2PaLM2 Parece Superar a GPT-4 en algunas tareas matemáticas, de traducción e inferencia. Pero la realidad puede no coincidir con los estándares de Google. En una evaluación rápida de la versión PaLM 2 de Bard realizada por Ethan Mollick, un profesor de Wharton que suele escribir sobre inteligencia artificial, Mollick descubrió que PaLM 2 funciona peor que GPT-4 y Bing en varias pruebas de lenguaje informales, lo cual es Bisagra en el hilo de Twitter.

Hasta hace poco, la familia de modelos de lenguaje PaLM era un producto interno de Google Research sin exposición a los consumidores, pero Google ha comenzado Proporcionar acceso limitado a la API en marzo. Sin embargo, el primer PaLM se destacó por su enorme tamaño: 540 mil millones de parámetros. Los parámetros son variables numéricas que sirven como «conocimiento» adquirido por el modelo, lo que le permite hacer predicciones y generar scripts basados en la entrada que recibe.

Más parámetros significan aproximadamente más complejidad, pero no hay garantía de que se utilicen de manera eficiente. En comparación, GPT-3 de OpenAI (a partir de 2020) tiene 175 mil millones de parámetros. OpenAI nunca ha revelado la cantidad de parámetros en GPT-4.

Y esto lleva a la gran pregunta: ¿Qué tan «grande» es PaLM 2 en términos de número de parámetros? Google no decirlo que frustró a algunos Expertos de la industria que a menudo hacen campaña por una mayor transparencia sobre lo que hace que los modelos de IA funcionen.

Esta no es la única característica de PaLM 2 que Google no ha pasado por alto. compañía Él dice dice que PaLM 2 ha sido entrenado en «una variedad de fuentes: documentos web, libros, código, matemáticas y datos de conversación», pero no entra en detalles sobre qué son exactamente esos datos.

Al igual que con otros conjuntos de datos de modelos de lenguaje grandes, es probable que el conjunto de datos de PaLM 2 incluya una amplia variedad de Material con copyright Utilizado sin permiso y materiales que pueden ser dañinos raspar Internet. Los datos de entrenamiento afectan críticamente el resultado de cualquier modelo de IA, por lo que algunos expertos han recomendado el uso de conjuntos de datos abiertos Puede brindar oportunidades para la reproducción científica y el escrutinio ético.

«Ahora que LLM es productos (y no solo investigación), estamos en un punto de inflexión: las empresas con fines de lucro se volverán *específicamente* menos transparentes sobre qué componentes son más importantes». chirrido Jesse Dodge, científico investigador de Instituto Allen de Inteligencia Artificial. «¡Solo si la comunidad de código abierto puede organizarse juntos podremos seguir el ritmo!»

Hasta ahora, las críticas por ocultar el ingrediente secreto no han impedido que Google busque un despliegue generalizado de modelos de IA, a pesar de la tendencia en todos los LLM de inventar cosas de la nada. Durante la conferencia Google I/O, los representantes de la compañía demostraron las funciones de IA en varios de sus productos estrella, lo que significa que una amplia muestra representativa del público pronto podría estar luchando contra los problemas de IA.

Y en términos de LLM, PaLM 2 está lejos del final de la historia: en el discurso de apertura de I/O, Pichai mencionó que un nuevo modelo de IA multimedia llamado «Gemini» estaba actualmente en entrenamiento. A medida que continúa la carrera por el dominio de la IA, los usuarios de Google en los Estados Unidos y 180 otros países (el extraño excepto Canadá y Europa continental) pueden Pruebe PaLM 2 ellos mismos Como parte de Google Bard, el asistente experimental de IA.

«Típico pionero de la cerveza. Aficionado a la web amigable con los hipsters. Fanático certificado del alcohol. Adicto a Internet. Exasperantemente humilde amante de los zombis».